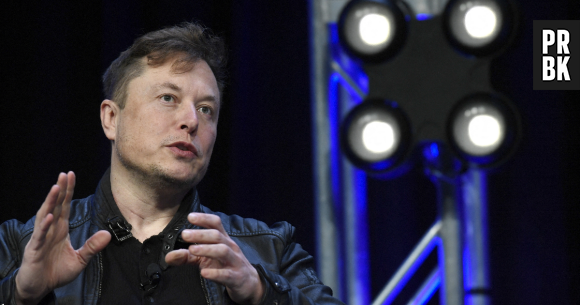

Elon Musk et 1 000 personnalités du monde technologiques demandent de stopper les essais sur des IA plus performantes que Chat GPT-4© ABACA

Elon Musk et 1 000 personnalités du monde technologiques demandent de stopper les essais sur des IA plus performantes que Chat GPT-4© ABACA

"Nous demandons à tous les laboratoires d'IA de suspendre immédiatement le façonnage des systèmes d'IA plus puissants que GPT-4 pendant au moins 6 mois." C'est le message diffusé dans la lettre ouverte signée, entre autres, par Elon Musk, Steve Wozniak (co-fondateur d'Apple), Jaan Tallinn (co-fondateur de Skype) et Max Tegmark (MIT). Cette lettre, signée par plus de 1 000 personnalités du monde technologique, remet en cause les avancées rapides des systèmes d'intelligence artificielle. Plus précisément, celles qui impliquent une capacité supérieure à celle de GPT-4.

La lettre précise tout d'abord que le développement des systèmes d'IA peut représenter un changement profond dans l'histoire, tant qu'il est correctement géré et planifié. Les signataires affirment que même les créateurs de ces systèmes ne sont pas capables, à ce jour, de comprendre ou de prédire de manière fiable leur comportement.

"Les systèmes d'IA contemporains viennent concurrencer les humains dans les tâches générales, et nous devons nous demander : devrions-nous laisser les machines inonder nos canaux d'information de propagande et de mensonges ? Devrions-nous automatiser tous les travaux ? Devrions-nous développer des esprits non humains ? finirons-nous par être en infériorité numérique, dépassés, obsolètes et remplacés ?", écrivent-ils.

La lettre ne fait pas allusion à une interruption complète du développement de l'IA, mais à ceux des systèmes avec plus de capacités que GPT-4. Ils demandent "un pas en arrière" dans la course vers "des modèles imprévisibles et aux compétences de plus en plus émergentes". Le point principal est que le développement actuel devrait se concentrer sur "rendre les puissants systèmes de pointe d'aujourd'hui plus précis, sécurisés, interprétables, transparents, robustes, alignés, fiables et loyaux". Autrement dit, mettre en pause le développement d'IA de plus en plus supérieures pour commencer à travailler en profondeur sur le contrôle et la fiabilité de ces systèmes.

Au-delà de travailler sur la fiabilité et la sécurité de ces systèmes d'intelligence artificielle, la nécessité de développer de nouveaux protocoles de sécurité partagés entre eux est demandée. "Ces protocoles devraient garantir que les systèmes qui y adhèrent sont sécurisés au-delà de tout doute raisonnable." Cela nécessite la création et le respect de certaines normes qui garantissent le bon fonctionnement de ces systèmes.

Ils ont également argumenté sur la nécessité de créer de nouvelles autorités de régulation de l'IA. Celles-ci, selon la pétition, devraient surveiller et suivre les "systèmes d'IA hautement performants" ainsi que trouver des moyens de distinguer le réel de ce qui a été créé artificiellement. On parle également de réglementation juridique en termes d'éventuels dommages créés par l'IA, de suivi d'éventuelles fuites de données ou de systèmes de financement public pour la recherche sécurisée. "Les institutions doivent disposer de ressources suffisantes pour faire face aux perturbations économiques et politiques drastiques (en particulier pour la démocratie) que l'IA entraînera."

La lettre n'aurait pas pu arriver à un moment plus approprié, car cela semble être la semaine où les modèles d'IA doivent être remis en question. Le 27 mars, la police européenne a averti que les réseaux criminels peuvent utiliser ces types d'outils à leur avantage. Les effets en termes de désinformation que peut avoir l'utilisation de ces outils, servant à créer des textes appliqués au phishing ou à d'autres fins malveillantes, ont été discutés.

Cet article a été écrit en collaboration avec nos collègues de Xataka

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2

player2